概述

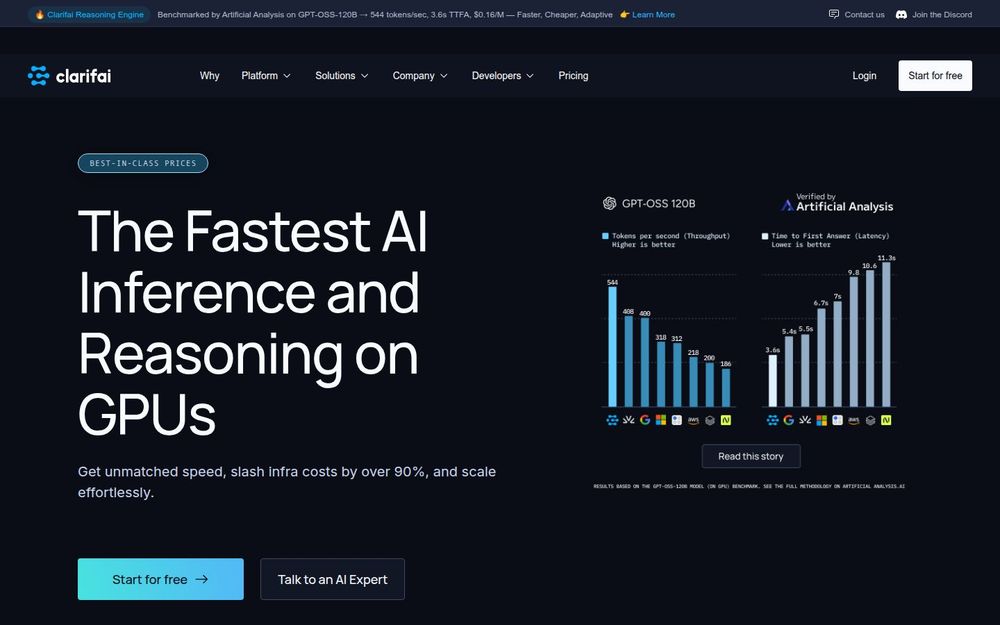

Clarifai 是一个面向企业和开发者的统一 AI 平台,主要目标是提供低延迟、高吞吐量、成本可控的模型推理与编排能力。平台支持从模型上传、部署、自动扩缩容到推理监控的全流程服务,兼容 OpenAI 标准接口,并通过专门的组件(如 Compute Orchestration、Local AI Runners、Control Center 等)实现本地与云端混合部署和集中化管理。

核心能力

-

低延迟推理: Clarifai 优化了推理路径,保障从请求到首个 token 返回的时间(TTFA)极短,适合对实时性要求高的应用。

-

高并发吞吐: 平台在高并发场景下仍能提供稳定的 token 吞吐量,支持大规模并发推理需求,适用于多用户协同或高查询量场景。

-

模型不可知与灵活部署: 支持上传自定义模型、主流开源模型和第三方闭源模型;提供 Serverless、Dedicated、Enterprise(自托管或混合云)等多种部署选项。

-

本地 AI Runners 与 MCP 支持: 通过 Local AI Runners 可以安全地将本地或私有服务器上的模型暴露至 Clarifai 控制面,从而在保留本地计算的同时享受云端管理能力;并支持 MCP(Model Context Protocol)服务器以实现 agentic AI 的外部工具与实时数据连接。

-

易用性与兼容性: 平台提供 OpenAI 兼容接口、Python SDK、NodeJS SDK 与强大的 CLI,使现有基于 OpenAI 的应用可以最小改动即可切换到 Clarifai;同时提供自动化部署与按需扩缩容功能,降低上生产门槛。

推荐原因

Clarifai 适合希望在性能、成本与可扩展性之间取得平衡的团队和企业。它通过优化的 GPU 推理与编排机制,声称能够在降低 90%+ 基础设施成本的同时提升响应速度,并且提供从快速原型到企业级部署的完整工具链。对需要多模型管理、本地与云混合部署、或希望平滑迁移现有 OpenAI 接口应用的用户,Clarifai 提供了成熟且灵活的解决方案。

适用场景与扩展

- 实时客服与对话系统:受益于极低延迟和快速首 token 返回。

- 大规模批量推理:凭借高并发吞吐支持海量请求处理。

- 本地敏感数据处理:通过 Local AI Runners 与混合部署策略满足合规与安全需求。

- 多模型与多云管理:统一控制台和自动部署工具简化运维与成本优化。

总结:Clarifai 将高性能推理、灵活部署与易用接口结合,适合对延迟、吞吐和成本敏感且需要跨本地/云部署能力的团队。